Архитектура системы управления для инвалидной коляски: на пути к многофункциональному роботу с нейробиологическими интерфейсами

Целью исследования явилось создание системы управления роботизированной коляски с расширяемым пользовательским интерфейсом для лиц с различными функциональными расстройствами.

Обсуждаются различные подходы к созданию роботизированной коляски для людей с ограниченными возможностями. Выбранный метод основан на когнитивном мультимодальном интерфейсе, повышающем автономность пользователя и позволяющем ему отдавать команды верхнего уровня управления. Для стратегического контроля могут использоваться такие средства, как ручное и голосовое управление, слежение за взглядом, мозго-машинный интерфейс, в то время как низкоуровневые операции выполняются интеллектуальной автономной системой управления. Семиотическая модель мира робота обрабатывает данные с сенсоров коляски и планирует ее действия в виде последовательности высокоуровневых задач (поведений) для системы управления.

Предложена архитектура программного и аппаратного обеспечения для роботизированной коляски и средств взаимодействия с пользователем через мультимодальный интерфейс. Поддерживаются несколько видов обратной связи, в том числе голосовые сообщения, вывод на экран, световые и тактильные сигналы.

В работе описаны некоторые новые решения, прошедшие апробацию на реальных робототехнических устройствах. Набор сенсорных устройств: дальномеры, камера, энкодеры — обеспечивает безопасность движения прототипа коляски и позволяет распознавать объекты и сцены. Опасное поведение робота блокируется встроенными рефлексами, поддерживается использование дополнительных процедур обеспечения безопасности системой планирования.

Разработанная архитектура позволяет применять для управления пользовательские интерфейсы, которые слишком медленны для традиционных типов автоматизации управления инвалидной коляской. Чтобы добиться требуемых точности и надежности, время обработки сигналов от голосового интерфейса, а также от интерфейсов «глаз–мозг–компьютер» и устройство отслеживания взгляда, увеличено. Снижение скорости отдачи команд компенсируется изменением их характера, потому что высокоуровневые команды управления требуется отдавать реже низкоуровневых. В перспективе это позволяет использовать в подобных системах управления и другие средства считывания параметров физиологических систем, например мозго-машинные интерфейсы и системы отслеживания взгляда, для непрямого управления мобильной техникой и других видов взаимодействия с ней.

Введение

Сегодня почти 10% людей с ограниченными возможностями, или 1% населения Земли, нуждаются в инвалидных колясках для передвижения [1]. Из них по разным причинам не обеспечены специализированными транспортными средствами около 40% [2], причем многие имеющиеся коляски недостаточно хорошо подходят для конкретных пациентов. Например, современные механизированные инвалидные коляски подразумевают прямое ручное управление движением, обычно с помощью джойстика, и множество людей с нарушенными моторными функциями не имеют возможности пользоваться ими. Этим обусловлены важность и актуальность создания многофункциональной коляски для людей с ограниченными возможностями, учитывающей все особенности функциональных нарушений. Предложенная в данной работе модульная система управления многофункциональной коляски позволяет применять ее для людей с разным уровнем и характером нарушений функциональных систем организма (в том числе для полностью парализованных).

Существует два главных пути взаимодействия людей с ограниченными физическими возможностями и технических устройств. Первый путь — это создание новых типов интерфейсов. Второй — упрощение процесса взаимодействия за счет интеллектуализации технических устройств и расширения их функционала. Наша работа посвящена созданию комплексной системы взаимодействия с роботизированной коляской для людей с ограниченными возможностями. Комбинация новых типов человеко-машинных интерфейсов (ЧМИ) и интеллектуальной системы управления может дать управлению новое качество. В конечном итоге коляска для людей с ограниченными возможностями должна реализовывать функции делегированной автономности, решая комплекс задач локального и глобального управления. С другой стороны, развитый интерфейс должен обеспечить пользователю управление коляской как на оперативном уровне, так и на уровне постановки задач или сценариев поведения. Иными словами, распоряжения пользователя должны сводиться к высокоуровневым последовательностям задач, а вся интерпретация и выполнение каждой из них будет возлагаться на автономную систему управления. Предполагается, что использование такого интерфейса на верхнем уровне облегчит процесс управления коляской, что сделает ее практически полезной для широкого круга людей с ограниченными возможностями, а также увеличит точностно-скоростные показатели.

Также следует отметить, что применение автономной системы управления с командами высокого уровня позволяет расширить спектр применимых ЧМИ, включая медленные нейроинтерфейсы на основе электроэнцефалографии (ЭЭГ) и функциональной спектроскопии ближнего ИК-диапазона (фСБИД), которые невозможно использовать для прямого управления на нижнем уровне. Пока что такие интерфейсы не способны обеспечить приемлемую скорость получения команд для непосредственного управления движением. Однако некоторые команды нижнего уровня так или иначе должны быть доступны пользователю, например команда аварийного резкого останова.

Таким образом, в качестве базовой архитектурной модели системы управления роботизированной коляски была выбрана сервис-ориентированная транспортная система с возможностью автономного функционирования. Мультимодальный ЧМИ будет служить для задания управляющих команд на верхнем уровне иерархии управления. Возможно и прямое управление по выбору пользователя.

Проблемы разработки систем управления инвалидной коляски

Важнейшая часть разработки роботизированной коляски — продуманный метод взаимодействия с пользователем. Интерфейсы многих сложных систем сейчас позволяют успешно работать людям с ограниченными возможностями, но в данном случае пользователи особенно разнообразны по своим требованиям. Практически каждый известный метод непригоден для некоторой группы пользователей. Роботизация коляски осложняется еще и тем, что управление должно выполняться в режиме реального времени в крайне разнообразных условиях, а цена ошибки может быть очень велика.

С тех пор как инвалидные коляски стали двигаться самостоятельно, предложено огромное количество способов управления ими. Эти способы можно классифицировать по типу используемых управляющих сигналов с учетом того, что часто сигналы разных типов комбинируют.

Если у человека сохранены двигательные функции конечностей, зрение и высшие психические функции, то проще всего организовать прямое управление коляской при помощи традиционных средств: кнопок, джойстика, руля или педалей. Однако при нарушении или ослаблении хотя бы одной из перечисленных функций прямое управление становится затруднительным, невозможным либо опасным.

В данной ситуации есть два возможных пути развития:

попытаться восстановить поврежденную функцию при помощи других сохраненных функций до уровня, необходимого для осуществления прямого управления;

реализовать схему непрямого управления, в которой оперативный контроль движением осуществляется полностью автоматически, а человек задает лишь команды высокого уровня: конечные точки маршрута или какие-либо дополнительные действия.

Первая стратегия имеет большую историю развития. Например, обычные очки позволяют исправить некоторые нарушения зрения. Использование миографических сигналов от сохраненных мышц дает возможность восстановить некоторые двигательные функции. Применение айтрекера позволяет осуществлять прямое управление движением при существенном нарушении мышечной регуляции.

Однако в некоторых случаях достичь необходимого быстродействия или точности не удается. Так, существующие нейроинтерфейсы на основе ЭЭГ или фСБИД имеют временнóе разрешение, измеряемое секундами, в оптимальных условиях [3], и не годятся для прямого управления. Для восстановления некоторых возможностей зрительных функций появились устройства, которые вербально описывают объекты, находящиеся перед человеком [4]. Они являются, несомненно, прорывом для людей с нарушением зрения, но их быстродействия также недостаточно для прямого управления. Что касается высших психических функций, то средства для их фасилитации находятся лишь на этапе исследований.

Вторая стратегия позволяет обойти ограничения, связанные с низким быстродействием и надежностью естественных или восстановленных функций. Например, для автоматической системы управления допустима низкая скорость подачи команд высокого уровня, порядка несколько минут, что доступно для всех существующих нейроинтерфейсов. Такая схема управления защищена от ошибок, так как в ней все команды допустимы, а оперативный контроль осуществляется автоматически, и может быть применена даже при некоторых видах нарушений высших психических функций, что невозможно для систем прямого управления.

В нашем исполнении мы применяем комбинацию этих стратегий:

возможность прямого управления при помощи джойстика;

фасилитацию двигательных функций для прямого управления с помощью айтрекера и электромиографии;

реализацию непрямого управления с подачей команд высокого уровня, при этом команды могут подаваться при помощи различных доступных человеку функций: речи, движений конечностями (кнопки, джойстик), движений глаз (айтрекер), мышечной активности (электромиография), биопотенциалов головного мозга (ЭЭГ), изменений кровотока головного мозга (фСБИД) или каких-либо других. Возможно также дублирование средств подачи непрямых команд для повышения надежности системы.

Рассмотрим возможные ЧМИ, пригодные для прямого и высокоуровневого управления.

Голосовое управление инвалидными колясками описано давно [5]. В первых разработках система распознавания обычно определяла отдельные слова-команды из короткого набора. Со временем были разработаны средства формирования команд на языке, близком к естественному, с точностью распознавания 97% [6]. При достаточно богатом распознаваемом языке можно обеспечить постановку высокоуровневых задач в удобном и понятном для человека виде. Среди недостатков такой системы отметим уязвимость к посторонним шумам и необходимость произносить команды четко для успешного распознавания.

Для управления можно использовать сигналы, возникающие в мышцах при напряжении. При таком подходе набору простых команд движения в определенном направлении или остановки соответствуют определенные сигналы датчиков, регистрирующих электрическую активность мышц. Для управления могут использоваться мышцы лица [7, 8], туловища и шеи [9], рук [10]. Как правило, считанные сигналы порождают команды, задающие направление движения, как и в случае управления джойстиком. Значительной проблемой для подобных систем являются ложные срабатывания из-за случайного сокращения мышц, в том числе от усталости (так, в последнем из указанных исследований доля ложных срабатываний достигала для отдельных мышц 50%).

Существуют разработки, использующие для управления движение взгляда. Этот подход весьма перспективен, так как он может позволить передвигаться самостоятельно даже тем, кому недоступно ни голосовое управление, ни напряжение мышц. Типы входных сигналов для таких систем весьма разнообразны. Иногда движение взгляда действует аналогично движению джойстика. В других случаях от пользователя требуется фиксировать взгляд на области пространства, куда он хотел бы переместиться, и система управления должна самостоятельно вычислить траекторию для достижения поставленной цели. Такой метод позволяет повысить уровень задач управления.

Отслеживание движения взгляда ставит ряд важных проблем. Необходимо каким-либо образом входить в режим движения и выходить из него с использованием специфических паттернов перемещения взгляда, не встречающихся при управлении движением. Необходимо также отличать контролируемое, намеренное смещение взгляда от случайного, вызванного непроизвольным перемещением глаза или усталостью (проблема «прикосновения Мидаса» [11]), и от контроля исполнения ранее отданной команды. Из-за этого сложность сигналов, которые могут устойчиво отдаваться человеком и распознаваться системой управления, ограничена. Более полное обсуждение данной проблемы приведено в работе [12]. Среди предлагавшихся способов борьбы с ложными срабатываниями можно упомянуть фиксацию взгляда на определенном предмете заданное время (порядка 0,5 с), предложенную в работе [13] на основе полученных ранее оценок времени фиксации при коммуникации [14].

Развиваются и методы управления по ЭЭГ-данным [15, 16], отражающим электрическую активность нейросетей головного мозга в когнитивных процессах. Их преимущество заключается в том, что считать мозговую активность можно у любого, даже полностью парализованного пациента, поэтому охват пользователей наиболее широк. Однако у этого подхода есть существенные недостатки: оператору необходим ассистент для подготовки к считыванию данных, качественная аппаратура для получения ЭЭГ стоит дорого, доля ошибочных считываний может достигать 50%. Например, из-за сложностей корректного считывания в работе [17] время считывания команды остановки достигало в среднем 5 с, что неприемлемо для практического применения. Однако там же отмечено, что при более высокоуровневом управлении — указании конечной точки маршрута — и большей интеллектуальности кресла надежность и скорость работы увеличиваются.

В последнее время ведутся исследования по применению фСБИД для задач мозго-компьютерных интерфейсов. Так как эта технология основана на изменении кровотока головного мозга человека (коррелирующем с электрической активностью нейросетей головного мозга), то ее скорость измеряется десятками секунд на команду [3]. Применение комбинированных систем — ЭЭГ и фСБИД — позволяет повысить скорость до единиц секунд и увеличить точность классификации команд до 98% [18]. Такие скорость и точность пригодны для подачи команд высокого уровня робототехническим устройствам, но недостаточны для прямого управления.

Многие представленные методы управления имеют существенные достоинства, но выбрать из них один, хорошо подходящий для всех групп пациентов, невозможно. Так как зачастую ошибки разных распознавателей управляющих сигналов проявляются независимо друг от друга, качество работы можно повысить сочетанием разных методов сбора данных в одной системе, определяющих разные физиологические показатели одного и того же когнитивного процесса. Так, предлагались многочисленные варианты, сочетающие отслеживание движения глаз и систему наблюдения за сектором обзора оператора [19]. Такие системы пытаются распознавать объекты, на которые направлен взгляд, и делают предположение о том, был этот взгляд сигналом управления или нет.

Концепция системы управления коляски и интерфейсы

Разрабатываемое архитектурное решение должно охватывать широкий спектр интерфейсных устройств. Однако все перечисленные методы взаимодействия с пользователем обладают существенными недостатками, которые делают оперативное, низкоуровневое управление инвалидной коляской ненадежным и небезопасным. Точность распознавания команд весьма мала, а повысить ее мешают принципиальные физиологические ограничения. При этом задержки реакции интерфейсов слишком велики для удобного и точного оперативного управления.

Эти ограничения можно преодолеть, если делегировать управление более высокому уровню. Вместо низкоуровневых команд движения пользователь может инициировать высокоуровневые действия, состоящие из множества команд, формируемых и контролируемых интеллектуальной системой управления коляской. Такое решение снижает требования ко времени реакции интерфейсов и ограничивает ущерб от неправильно распознанных команд.

Высокоуровневая система управления позволяет комбинировать интерфейсы, лучше всего подходящие для конкретного оператора. Некоторые интерфейсные устройства пригодны и для высокоуровневых, и для низкоуровневых команд (джойстик, миодатчики, айтрекер), другие — преимущественно для высокоуровневых. Для работы с устройствами разных классов системе необходимо одновременно анализировать команды разных уровней, поэтому она должна иметь мощные средства описания сложных форм поведения на основе простых.

При реализации высокоуровневого управления, необходимого для решения проблемы задержек в случае оперативного (низкоуровневого) управления, возникает задача определения команд пользователя. Поскольку высокоуровневые команды обладают большим количеством различных вариаций и могут быть связаны с наблюдаемыми объектами, в отличие от низкоуровневых команд движения, требуется применение моделей и методов, способных работать с этими понятиями. Одним из таких подходов является архитектура, использующая семиотические сети [20] (далее подход называется семиотическим управлением). Также способны работать с объектами и понятиями методы на основе онтологий (например, RoboBrain [21] и SO-MRS для мультиагентных систем [22]), но в них основное внимание уделяется проблеме передачи знаний о понятиях между роботами, а также связыванию объектов и понятий. В то же время такая понятийная система выступает внешним источником знаний. В предлагаемом подходе, напротив, семиотическая структура является интегрирующим механизмом: семиотическая сеть объединяет в единой системе механизмы активации действий, описания модели мира, целеполагания агента и связи с командами оператора на естественном языке. Поскольку команды (и даже просто утверждения), произносимые человеком, удобно представлять в описании, оперирующем понятиями, то их естественно перенести на систему управления, которая планирует действия на основе сети, содержащей понятия.

Задачи автоматизации управления коляской на нижнем уровне ставятся и решаются отдельно. Должны быть реализованы следующие механизмы.

1. Низкоуровневые рефлексы. Рефлексы нижнего уровня отвечают за экстренное торможение коляски в случае нештатной ситуации — столкновения с препятствием, опасности падения с высоты и т.д.

2. Система технического зрения. Поскольку интерфейс подразумевает общение с человеком, некоторые высокоуровневые команды так или иначе будут сформулированы в понятных человеку терминах. Так, вполне естественно ожидать от оператора команду «подъехать к столу». Для ее выполнения потребуется найти в окружающем пространстве стол, чтобы построить маршрут к нему.

3. Система навигации и локализации. Распознавание характерных объектов окружения с возможностью построения карты крайне важно для успешного ориентирования.

4. Система построения и отработки маршрута. Данная система должна привести коляску из ее стартового положения в точку, указанную пользователем, избегая при этом столкновений и опасных зон.

Семиотическая модель мира робота

Основным элементом системы управления является семиотическая сеть [20], состоящая из знаков и связей между ними за счет правил. Средство описания системы — грамматика, применяющая логику первого порядка. Интеллектуальная инвалидная коляска имеет многоуровневую структуру управления: у нее есть собственные сенсоры, эффекторы, система рефлексов и некоторые другие низкоуровневые элементы. Все эти компоненты связаны между собой за счет знаковой системы, которая описывает элементы перцепции (сенсорики) и действия с помощью знаков. Имена знаков позволяют связывать семантические сети, формируемые системой анализа текстовой команды, и семиотическую сеть, служащую моделью мира агента. При этом отдельные элементы объединяются в знаки, которые могут далее связываться в более абстрактные высокоуровневые конструкции (пример — знак «гостиная», являющийся подклассом знака «комната»). Поскольку система способна работать с ограниченным набором понятий, определяемым сенсорными возможностями и встроенными алгоритмами действий нижнего уровня, то в качестве описания интерфейса между системой анализа речи и управляющей системой на основе семиотической сети используется фиксированный словарь имен знаков (типов объектов), атрибутов и действий.

Знаки, описывающие картину мира, составляются из утверждений (замкнутых атомарных формул логики первого порядка) и операторов STRIPS, представляющих собой тройки (или продукции) R:

где C — условие применимости оператора в виде множества утверждений; A — множество добавляемых оператором утверждений; D — множество удаляемых утверждений.

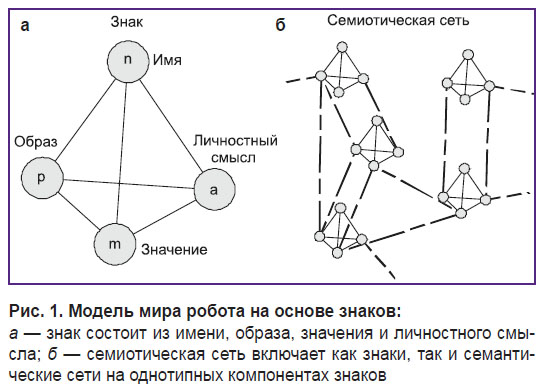

Все воспринимаемые агентами сущности в семиотической картине мира представляются знаками. Формально каждый знак описывается упорядоченным множеством четырех компонентов (рис. 1):

где имя n связывает элементы семантической сети команды, получаемой из анализа речи, и знак в системе управления;

образ p состоит из наблюдаемых (или доступных для распознавания сенсорикой) утверждений об означаемой сущности;

функциональное значение m является набором операторов STRIPS [см. формулу (1)], позволяющих с помощью логического вывода дополнить информацию о мире, которая не наблюдается напрямую;

личностный смысл a включает в себя набор действий, относящихся к знаку, каждое из которых соответствует оператору STRIPS [см. формулу (1)].

Семантикой конкретного действия является низкоуровневый (описанный вне знаковой системы) алгоритм, реализуемый стандартными методами управления, например конечным автоматом. Семантикой образа p некоторого знака являются алгоритмы распознавания системы восприятия, напрямую определяющие наличие данного свойства у наблюдаемого объекта (или в целом у сцены).

Описание знаков и связей между ними осуществляется с помощью языка логики первого порядка. Тройки условий, добавлений и удалений являются операторами STRIPS, которые при логическом выводе применяются один раз в определенном порядке, а при планировании позволяют воспользоваться алгоритмом, похожим на метод STRIPS [23], но пользующимся знаковым описанием задачи. Стоит отметить, что для систем управления на основе семиотической сети планирование STRIPS уже применялось в работе [24], хотя и несколько иным способом. Тем не менее этот метод подходит для моделей такого типа.

Алгоритм планирования STRIPS использует изменяемое состояние в виде списка истинных фактов и с помощью операторов осуществляет поиск в пространстве состояний. В предлагаемом нами методе эти операторы применяются для обновления информации о внешней среде в модели мира робота путем дополнения фактов о новом состоянии среды, а не только для планирования, а состояние мира сохраняется между последовательными действиями робота. Это означает, что порядок применения операторов важен, а построенная логическая система может быть немонотонной. Несмотря на эти проблемы, такой способ позволяет ускорить обновление фактов о мире на каждом шаге за счет сохранения тех фактов, которые были выведены ранее, если они не противоречат новым данным. Это позволяет также реализовать в знаковой системе память, так как факты, не выводимые напрямую из текущих наблюдений, остаются в базе знаний агента.

На нижнем уровне могут использоваться различные реализации действий (например, конечные автоматы или иерархические стратегии). И тот, и другой методы используют переход между состояниями как естественный способ разбиения задач управления на этапы. Такой переход может, например, осуществляться при завершении выполнения самого базового действия в иерархии. В промежутках между такими действиями управление проходит остальную часть цикла: данные с сенсоров используются для обновления семиотической сети, являющейся базой знаний агента. Затем последовательно выполняются логический вывод, планирование и обработка команд пользователя.

Активность интеллектуального агента обеспечивается за счет интенционального механизма, т.е. тех алгоритмов и структур данных, которые запускают действия агента, направленные на достижение конкретной цели. Для безопасности один из рефлекторных уровней реализуется вне знаковой системы (отвечающей за «когнитивные» процессы), на нижнем уровне, и способен перехватывать управление для избегания столкновений. Помимо команд пользователя система должна также учитывать окружающую обстановку и заботиться о безопасности оператора. Выполнение команды может потребовать ряда различных последовательных действий, прерываемых рефлексами, в условиях изменяющейся обстановки и необходимости перепланирования. Все это заставляет рассматривать команду пользователя как цель, которую следует учитывать в процессе выполнения, но не считать единственным назначением всех идущих в системе процессов. Скорее, сама система должна быть спроектирована исходя из ее собственной активности и набора внутренних механизмов, регулирующих поведение. Примером архитектуры, поддерживающей концепцию автономного целеполагания, является эмоционально-потребностная архитектура [25], однако в нее без модификаций тяжело ввести внешнее управление в виде команд. Вместо этого можно частично описать потребности в знаковом представлении в виде правил, входящих в состав значений (т.е. составляющей знака m). Выбор удовлетворяемой потребности при этом дополнен внешним по отношению к семиотической модели алгоритмом.

Для принятия решения о своем следующем действии агенту необходимо также определить, какие из условий действий в личностных смыслах выполнены. Эти условия могут содержать как проверки предикатов в образах знаков, так и факты, добавляемые операторами из значений знака (элементов из m).

Система управления робота

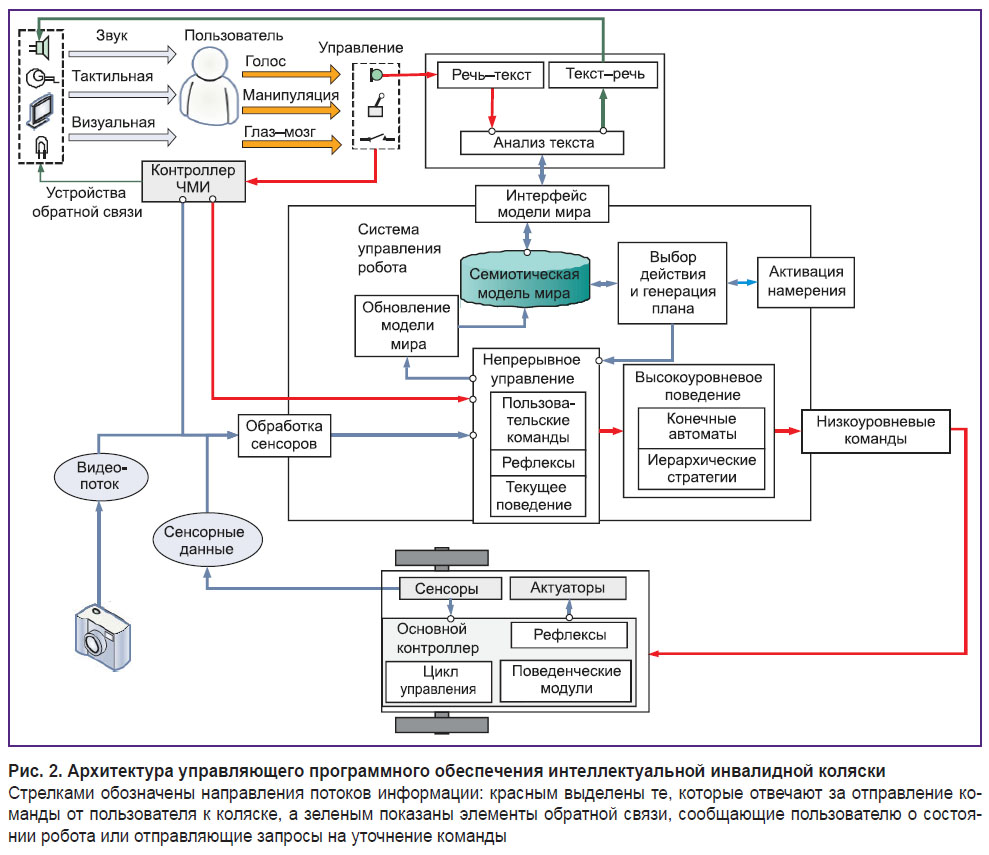

Рассмотрим программную архитектуру системы управления (СУ) робота и ее внешние интерфейсы (рис. 2). Эта система обладает мультимодальным вводом и выводом, которые по возможности обеспечивают схожие интерфейсы для поддержки как можно большего количества пользователей с различными ограничениями возможностей и для повышения эффективности взаимодействия с коляской.

Подсистема ввода состоит из микрофона, механических манипуляторов (джойстика, кнопок), системы глазодвигательного управления на основе айтрекера, нейроинтерфейсов на основе миограммы, ЭЭГ и фСБИД. Стандартный режим работы предполагает отдачу высокоуровневых команд, т.е. постановку целей интеллектуальной коляске, однако предусмотрена и возможность активации более низкого уровня (оперативного) управления движением напрямую. В качестве обратной связи человек получает голосовые сообщения (например, о невозможности выполнения команды или содержащие просьбу уточнить команду), сообщения на экране, а также различные индикации светодиодов и сигналы системы тактильной обратной связи. Эти две системы устройств ЧМИ связаны с компьютером через ЧМИ-контроллер либо напрямую.

Нижний уровень СУ робота, непосредственно взаимодействующий с аппаратной составляющей, включает в себя камеру, набор датчиков (дальномеры и энкодеры), актуаторы (двигатели) и управляющий контроллер, который координирует их взаимодействие с компьютером. Основной контроллер робота использует практически сырые данные с датчиков для реализации простых низкоуровневых паттернов поведения, таких как движение вперед с избеганием столкновений, движение вдоль стены, объезд препятствия и т.п. Он также обладает рефлекторной системой на основе дальномеров, которая может в любой момент заблокировать опасное низкоуровневое действие, чтобы избежать столкновения. Видеопоток отправляется напрямую на систему обработки изображений. Обработку проходят и остальные данные датчиков, перед тем как использоваться в управляющей системе на стороне компьютера.

На верхнем уровне управляющая система основана на семиотической модели мира. На вход она получает обработанные данные в виде объектов, отношений между ними, относительного положения препятствий. Эти сведения дополняются логическим выводом за счет информации, хранящейся в известных системе знаках. На основе знакового описания мира происходит планирование, которое либо выбирает непосредственно действие для выполнения, либо создает план из набора высокоуровневых действий (поведений). При этом активация планирования и выполнения действий может быть вызвана несколькими разными механизмами: непосредственно командой пользователя или же внутренней интенциональной системой. Она участвует в процессе выбора текущей цели, даже если пользователь установил какую-то иную цель. Это необходимо для того, чтобы дать возможность СУ балансировать между безопасностью работы и непосредственным выполнением желания пользователя. Системы планирования, целеполагания и модели мира объединяются модулем непрерывного управления, который на каждом шаге работы СУ запускает необходимые процессы обновления модели мира, планирования, следит за командами пользователя и передает высокоуровневые команды на выполнение. Он же содержит еще одну систему рефлексов, которые позволяют прервать опасное поведение коляски на основе анализа датчиков, доступного только высокоуровневой системе, и не может отслеживаться на уровне основного контроллера.

Высокоуровневые команды, задающие поведение, могут быть реализованы разными способами и не описываются напрямую в знаковой системе: в ней лишь имеется информация об их наличии, условиях активации и ожидаемых последствиях. Удобно использовать, например, конечные автоматы, или так называемые опции — иерархические стратегии, упоминаемые в контексте обучения с подкреплением [26]. В свою очередь, они отправляют низкоуровневые команды контроллеру (например, поведение «найди объект» может пользоваться командами движения, объезда препятствий и движения к наблюдаемому объекту по камере).

Подсистема речевого взаимодействия состоит из модуля распознавания и генерации речи и модуля, занимающегося анализом текстового сообщения и преобразованием его в семантические сети, передаваемые в качестве команд подсистеме управления инвалидной коляски. Получение пользователем результатов выполнения команд или запросов на уточнение также происходит в словесном виде с помощью модуля генерации речи, а команды вводятся модулем распознавания. Язык взаимодействия с пользователем приближен к естественному. В частности, когда полученной информации недостаточно для создания команды, знаковая система управления формирует запрос на уточнение неоднозначных распоряжений. Связь речевого модуля с управляющей системой осуществляется с помощью специального модуля, который использует словарь понятий системы (атрибутов объектов, которые пользователь может применять при описании, а также типов объектов, известных действий) для преобразования семантической сети во фрагмент модели мира. Этот же модуль проверяет саму возможность такого преобразования, при необходимости отправляя запрос на уточнение элементов команды или сообщение о ее невыполнимости.

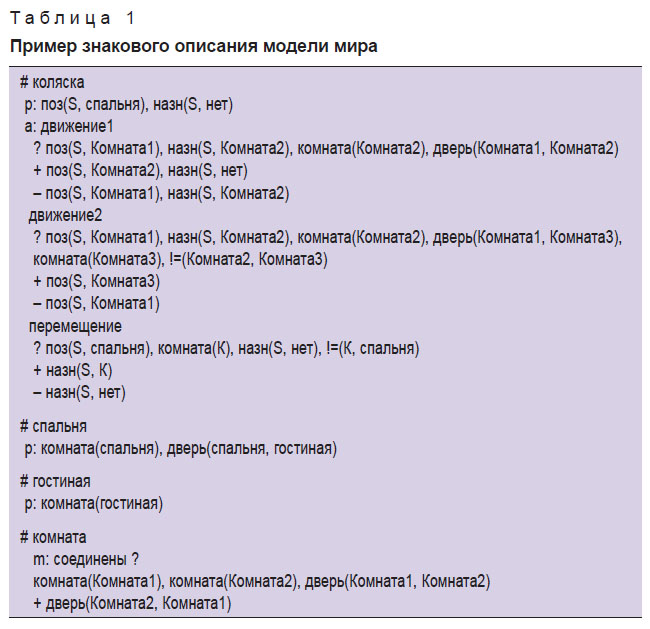

Пример знакового описания модели мира интеллектуальной коляски приведен в листинге табл. 1. Данное описание включает знаки «коляска», «спальня», «гостиная», «комната», в образы которых включены утверждения об их классовой принадлежности (объект с именем «спальня» является «комнатой»), формирующие один из типов иерархий в этой семиотической сети, а также атрибуты («назн» — выбранное место назначения, «поз» — позиция (положение), S — имя текущего знака). Описание каждого знака начинается с символа «#», после которого следует список предикатов образа (обозначены «p»), список значений («m») и личностных смыслов («а»). Каждый оператор-правило, в свою очередь, описано названием, набором условий после знака «?», списком добавляемых правилом предикатов после символа «+» и списком удаляемых предикатов после символа «–». Названия связанных переменных для удобства начинаются с большой буквы; название текущего знака всюду принято равным «S».

|

Таблица 1. Пример знакового описания модели мира |

Описанная модель содержит операторы, позволяющие вывести некоторые факты из других знаний, связанных со знаком: оператор «соединены» утверждает, что при наличии двери между комнатами в одну сторону также имеется и проход в обратную сторону (коммутативность предиката «дверь»). Такие операторы хранятся в части знака «m».

Имеющиеся в модели действия (часть знака «a») описаны в виде STRIPS-операторов «движение1», «движение2», «перемещение» со списками условий возможности выполнения, добавлением и удалением фактов. Все они относятся к агенту «коляска».

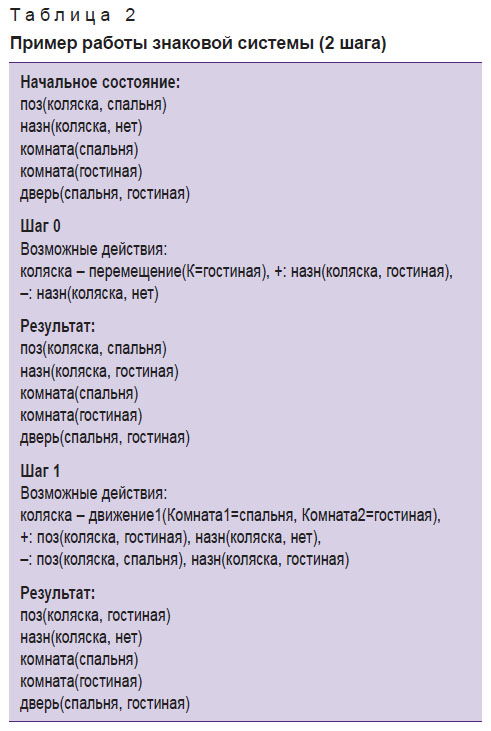

Рассмотрим автономную работу агента в вышеописанной ситуации. В данной системе для наглядности агент обладает активными намерениями даже без внешних стимулов или команд человека-оператора (инвалида). Конечно же, в реальной системе мотивации агента должны быть устроены так, чтобы он лишь реагировал на различные нежелательные ситуации и пожелания человека, а не выполнял какие-то действия самостоятельно. Начальное состояние системы описано в одноименной части листинга табл. 2. «Коляска» знает о своем положении в комнате «спальня», не имеет никакого назначения, а также обладает информацией о существовании комнат «спальня», «гостиная» и о наличии двери из «спальни» в «гостиную». В этом примере не используется эмоциональный или иной механизм целеполагания, задаваемый внешней интенциональной системой (не описанной внутри знаковой системы), поэтому агент выбирает первое из возможных в данной ситуации действий. Оператор «перемещение» является единственным действием, которое доступно для выполнения на этом шаге, поэтому оно выполняется, и база знаний агента пополняется в соответствии со списками добавления и удаления (т.е. ставится цель «движение в комнату “гостиная”»). На следующем шаге выбирается и выполняется действие, позволяющее достичь поставленную перед агентом цель (предикат места назначения «назн»). В этом примере не отражено наличие промежуточного шага, выполняемого перед следующей знаковой обработкой ситуации — обновления перцептов в соответствии с наблюдаемой ситуацией с сенсоров, однако важно заметить, что подобный шаг может ввести конфликтующие факты в базу знаний. В таком случае необходимо повторить логический вывод, пользуясь всеми известными операторами из «m» и считая данные, полученные с сенсоров, истинными в любых конфликтных ситуациях. Таким образом, описанная знаковая система реализует автономное поведение с целеполаганием со стороны интеллектуального агента (коляски).

|

Таблица 2. Пример работы знаковой системы (2 шага) |

Компоненты подсистемы восприятия

Важной частью знаковой системы управления является теоретическая возможность порождать новые знаки. Образы знака можно переложить в описание объекта в терминах системы распознавания. Такой подход естественным образом вписывается в концепцию разрабатываемой семиотической архитектуры системы в целом. Каждый объект, требующий распознавания, может и должен соответствовать знаку. Реализация такого механизма позволит расширять базу объектов по ходу работы.

В основе системы технического зрения лежат недоопределенные модели [27]. Метод выделения «сложных» объектов, или сцен, описан подробно в работе [28]. Он представляет собой итерационную процедуру, которая на каждом шаге работы уменьшает область неопределенности переменных согласно приведенным ограничениям, на них накладываемым, тем самым получая ответ. Данный метод показал работоспособность для различных конфигураций сцен, а также приемлемую вычислительную сложность, в сравнении с некоторыми другими методами распознавания, на интересующем классе сцен.

Разработанная на этой основе система технического зрения, предназначенная для распознавания объектов с разными описаниями, представлена в работе [29]. Первой особенностью этой системы является возможность задавать объект как набор признаков или атрибутов. Атрибуты характеризуют вид объекта с разных сторон по форме, цвету, размеру и другим особенностям, а соответствующие атрибутам программные детекторы распознают объект на изображении. Распознавание происходит посредством пересечения областей, которые выделил каждый из представленных детекторов. Такая архитектура позволяет задавать широкий класс объектов и отделять их друг от друга, настраивая параметры и композиции атрибутов. Предполагается совместное использование такого метода вместе с другими типами распознавателей (например, основанными на сверточных нейросетях). Это позволяет обнаружить дверные проемы любым подходящим методом, после чего дополнить информацию об объекте детектором цвета, для того чтобы отличить одну дверь от другой по цвету. Второй особенностью предложенной системы является возможность комбинировать объекты друг с другом при помощи введения отношений, что также расширяет распознаваемый класс объектов. Например, базовый простой объект «стол», дополненный объектами из класса «столовые приборы» при помощи отношения «стоять на», может быть распознан как «обеденный стол»; если дополнить его объектами класса «канцелярские предметы», он будет являться «офисным» или «рабочим» столом.

Система локализации

Интеграция метода управления на основе знаков с системой локализации возможна с использованием механизма распознавания сцен. Данная система подразумевает локализацию по визуальным ориентирам, что приемлемо для работы коляски в детерминированных помещениях (например, дома или в рабочей обстановке), и обеспечивает навигацию на верхнем, стратегическом уровне. Распознанные системой технического зрения ориентиры, а также сцена, которую они образуют, отправляются в знаковую систему планирования маршрута, которая в свою очередь формирует план движения с помощью метода, описанного выше. Система локализации мобильного робота на основе визуальных ориентиров была описана и апробирована в работе [30].

Однако для движения коляски в пространстве одного стратегического плана недостаточно. Элементы полученного плана движения интерпретируются тактическим уровнем в последовательность команд для двигателей. Чтобы ее получить, требуется более точная локальная навигация. Для этого целесообразно прибегнуть к одновременной локализации и построению карт (SLAM). Это широкий класс методов [31–34] с разнообразными модификациями как по принципу обработки информации, так и по типу входных данных. Входными данными для методов SLAM могут быть как показания различных сенсоров, в частности дальномеров, так и данные с видеокамер, при этом как по стереопаре, так и по монокамере.

Важно отметить, что описанная выше система технического зрения обслуживает оба уровня локализации. Для стратегического уровня распознаются объекты в пространстве, отличающие их признаки и, что особенно важно, сцены, которые в дальнейшем интерпретируются в знаковую систему, чтобы построить план движения. Для тактической локализации также применяется информация об объектах и их свойствах, требующихся для вычисления положения коляски методами SLAM (поверхности, ключевые точки и т.п.).

Для апробации разработанных решений был создан прототип автоматизированной инвалидной коляски (рис. 3).

Прототип управляется специализированным контроллером, взаимодействующим с оборудованием сбора данных через бортовой компьютер. Сенсорные компоненты включают в себя набор сонаров, установленных по периметру, и блок распознавания объектов по видеоданным. Рефлекторные реакции сонаров обеспечивают безопасность езды. Прототип в дальнейшем будет использован как основа для экспериментов по комбинированию разных видов управляющих воздействий. Уже успешно работают двигательный сценарий свободного блуждания, рефлексы нижнего уровня, локализация с помощью алгоритма MonoSLAM.

Заключение

Разработка качественной и универсальной роботизированной инвалидной коляски — сложная задача, которую пытаются решить давно. Одной из основных не решенных до конца проблем является выбор средства взаимодействия с пользователем, обеспечивающего эффективный и безопасный контроль действий. Для управления движением можно применять сигналы самой разной природы — команды джойстика, голос, мышечную активность, движение взгляда, энцефалографические данные, но все эти варианты имеют существенные недостатки. Точность распознавания команд часто слишком мала для качественного управления, а повышать ее путем более сложных и долгих процедур обработки не позволяют требования безопасности. Часть этих решений не универсальна, другие более универсальны, но сложны и дороги. Наиболее рациональный выход из данной ситуации — разработка более интеллектуальной комплексной системы управления, способной по заданию пользователя самостоятельно планировать действия коляски с соблюдением норм безопасности и высокой надежностью, а также развитие технологий многомодальных человеко-машинных интерфейсов для подачи команд высокого уровня. Это решение снижает требования к скорости распознавания команд, что позволяет повысить точность распознавания, отклонить недопустимые команды, а также применить более широкий спектр технологий человеко-машинного взаимодействия для компенсации большего числа функциональных нарушений человека.

Для повышения уровня управления необходимо описывать высокоуровневые, понятные пользователю действия коляски через комплексы низкоуровневых. Такое решение делает формулировку задания более понятной для пользователя, что облегчает обучение. Особенно перспективно выглядит применение в данной задаче разрабатываемых пассивных нейроинтерфейсов, которые позволят использовать для управления естественные действия человека при обдумывании пространственного перемещения. Благодаря этому можно будет вовсе избежать обучения оператора использованию интерфейса.

В качестве средства описания сложного поведения, слагающегося из более простых компонентов, предлагается использовать семиотическую модель мира робота. Это универсальное представление позволяет собирать данные из источников различной природы, анализировать их и запускать исполнение тех или иных примитивных действий. Выбранный метод позволяет сочетать в едином сценарии компоненты, выполняющие отдельные этапы решения поставленной задачи, и управлять их совместной работой посредством конечных автоматов. Некоторые программные модули, выполняющие низкоуровневые действия, ранее разработаны и апробированы в лаборатории робототехники Курчатовского института в составе системы управления макетом подвижной платформы на основе фреймворка ROS: методы локальной и глобальной навигации, управления движением робота, рефлекторных реакций, распознавания ориентиров и точного позиционирования. В лаборатории нейротехнологий Курчатовского института разработаны и апробированы системы низкоуровневого и высокоуровневого управления на основе регистрации движений глаз и миограммы. Сочетание этих компонентов и гибкой системы описания взаимодействий обеспечит модульность и расширяемость полученного решения. В дальнейшем для планирования сложных действий и упрощения мониторинга будут применятся средства ситуационного управления.

Финансирование исследования. Работа выполнена при поддержке НИЦ «Курчатовский институт» (приказ №1601 от 05.07.2018).

Конфликт интересов. Авторы заявляют об отсутствии конфликтов интересов, о которых необходимо сообщить.

Литература

- World Health Organization. The world report on disability. 2011.

- Report of a consensus conference on wheelchairs for developing countries. Edited by Sheldon S., Jacobs N.A. Bengaluru, India; 2006.

- Shin J., Kwon J., Choi J., Im C.-H. Performance enhancement of a brain–computer interface using high-density multi-distance NIRS. Sci Rep 2017; 7(1): 16545, https://doi.org/10.1038/s41598-017-16639-0.

- Na’aman E., Shashua A., Wexler Y. User wearable visual assistance system. Patent US 2012/0212593 A1. 2012.

- Clark J.A., Roemer R.B. Voice controlled wheelchair. Arch Phys Med Rehabil 1977; 58(4): 169–175.

- Nishimori M., Saitoh T., Konishi R. Voice controlled intelligent wheelchair. In: SICE annual conference. IEEE; 2007, p. 336–340, https://doi.org/10.1109/sice.2007.4421003.

- Tamura H., Manabe T., Goto T., Yamashita Y., Tanno K. A study of the electric wheelchair hands-free safety control system using the surface-electromygram of facial muscles. In: Liu H., Ding H., Xiong Z., Zhu X. (editors). Intelligent robotics and applications. ICIRA 2010. Lecture Notes in Computer Science. Springer, Berlin, Heidelberg; 2010; p. 97–104, https://doi.org/10.1007/978-3-642-16587-0_10.

- Kim K.-H., Kim H.K., Kim J.-S., Son W., Lee S.-Y. A biosignal-based human interface controlling a power-wheelchair for people with motor disabilities. ETRI Journal 2006; 28(1): 111–114, https://doi.org/10.4218/etrij.06.0205.0069.

- Yulianto E., Indrato T.B., Suharyati. The design of electrical wheelchairs with electromyography signal controller for people with paralysis. Electrical and Electronic Engineering 2018; 8(1): 1–9.

- Hardiansyah R., Ainurrohmah A., Aniroh Y., Tyas F.H. The electric wheelchair control using electromyography sensor of arm muscle. Int Conf Inf Commun Technol Syst 2016; 2016: 129–134, https://doi.org/10.1109/icts.2016.7910286.

- Jacob R.J.K. The use of eye movements in human-computer interaction techniques: what you look at is what you get. ACM Trans Inf Syst 1991; 9(2): 152–169, https://doi.org/10.1145/123078.128728.

- Fedorova A.A., Shishkin S.L., Nuzhdin Y.O., Velichkovsky B.M. Gaze based robot control: the communicative approach. In: 7th International IEEE/EMBS conference on neural engineering (NER). IEEE; 2015; p. 751–754, https://doi.org/10.1109/ner.2015.7146732.

- Ingram R. Eye-tracking wheelchair developed by DoC researchers featured in Reuters video. 2014. URL: http://www.imperial.ac.uk/news/152966/eye-tracking-wheelchair-developed-doc-researchers-featured.

- Velichkovsky B.M. Communicating attention: gaze position transfer in cooperative problem solving. Pragmatics & Cognition 1995; 3(2): 199–223, https://doi.org/10.1075/pc.3.2.02vel.

- Ben Taher F., Ben Amor N., Jallouli M. EEG control of an electric wheelchair for disabled persons. International Conference on Individual and Collective Behaviors in Robotics 2013; 2013: 27–32, https://doi.org/10.1109/icbr.2013.6729275.

- Swee S.K., Teck Kiang K.D., You L.Z. EEG controlled wheelchair. MATEC Web of Conferences 2016; 51: 02011, https://doi.org/10.1051/matecconf/20165102011.

- Rebsamen B., Guan C., Zhang H., Wang C., Teo C., Ang M.H. Jr., Burdet E. A brain controlled wheelchair to navigate in familiar environments. IEEE Trans Neural Syst Rehabil Eng 2010; 18(6): 590–598, https://doi.org/10.1109/tnsre.2010.2049862.

- Naseer N., Hong K.-S. fNIRS-based brain-computer interfaces: a review. Front Hum Neurosci 2015; 9: 3, https://doi.org/10.3389/fnhum.2015.00003.

- Frisoli A., Loconsole C., Leonardis D., Banno F., Barsotti M., Chisari C., Bergamasco M. A new gaze-BCI-driven control of an upper limb exoskeleton for rehabilitation in real-world tasks. IEEE Transactions on Systems, Man, and Cybernetics, Part C 2012; 42(6): 1169–1179, https://doi.org/10.1109/tsmcc.2012.2226444.

- Осипов Г.С., Панов А.И., Чудова Н.В., Кузнецова Ю.М. Знаковая картина мира субъекта поведения. М: Физматлит; 2018.

- Saxena A., Jain A., Sener O., Jami A., Misra D.K., Koppula H.S. RoboBrain: large-scale knowledge engine for robots. 2014. URL: https://arxiv.org/abs/1412.0691v2.

- Skarzynski K., Stepniak M., Bartyna W., Ambroszkiewicz S. SO-MRS: a multi-robot system architecture based on the SOA paradigm and ontology. Lecture Notes in Computer Science 2018; 10965: 330–342, https://doi.org/10.1007/978-3-319-96728-8_28.

- Fikes R.E., Nilsson N.J. Strips: a new approach to the application of theorem proving to problem solving. Artificial Intelligence 1971; 2(3–4): 189–208, https://doi.org/10.1016/0004-3702(71)90010-5.

- Киселев Г.А., Панов А.И. STRIPS постановка задачи планирования поведения в знаковой картине мира. В кн.: Информатика, управление и системный анализ. Тверь; 2016; с. 131–138.

- Karpov V. The parasitic manipulation of an animat’s behavior. Biologically Inspired Cognitive Architectures 2017; 21: 67–74, https://doi.org/10.1016/j.bica.2017.05.002.

- Sutton R.S., Barto A.G. Reinforcement learning: an introduction. IEEE Transactions on Neural Networks 1998; 9(5): 1054–1054, https://doi.org/10.1109/tnn.1998.712192.

- Narin’yani A.S., Borde S.B., Ivanov D.A. Subdefinite mathematics and novel scheduling technology. Artificial Intelligence in Engineering 1997; 11(1): 5–14, https://doi.org/10.1016/0954-1810(96)00015-5.

- Московский А.Д. Метод распознавания сцен на основе недоопределенных моделей. В кн.: Шестнадцатая национальная конференция по искусственному интеллекту с международным участием КИИ-2018 (24–27 сентября 2018 г., Москва, Россия). Том 2. М: НИУ ВШЭ; 2018; с. 27–34.

- Московский А.Д. Об одном методе распознавания объектов с не полностью определенными признаками. В кн.: Третий Всероссийский научно-практический семинар «Беспилотные транспортные средства с элементами искусственного интеллекта» (БТС-ИИ-2016, 22–23 сентября 2016 г., Иннополис, Республика Татарстан, Россия). М: Из-во «Перо»; 2016; c. 137–146.

- Karpov V., Migalev A., Moscowsky A., Rovbo M., Vorobiev V. Multi-robot exploration and mapping based on the subdefinite models. In: Ronzhin A., Rigol G., Meshcheryakov R. (editors). Interactive collaborative robotics. Springer International Publishing; 2016; p. 143–152, https://doi.org/10.1007/978-3-319-43955-6_18.

- Davison A.J., Reid I.D., Molton N.D., Stasse O. MonoSLAM: real-time single camera SLAM. IEEE Trans Pattern Anal Mach Intell 2007; 29(6): 1052–1067, https://doi.org/10.1109/tpami.2007.1049.

- Engel J., Schöps T., Cremers D. LSD-SLAM: large-scale direct monocular SLAM. In: Fleet D., Pajdla T., Schiele B., Tuytelaars T. (editors). Computer vision — ECCV 2014. ECCV 2014. Lecture Notes in Computer Science. Springer, Cham; 2014; p. 834–849, https://doi.org/10.1007/978-3-319-10605-2_54.

- Mur-Artal R., Montiel J.M.M., Tardos J.D. ORB-SLAM: a versatile and accurate monocular SLAM system. EEE Trans Robot 2015; 31(5): 1147–1163, https://doi.org/10.1109/tro.2015.2463671.

- Milford M.J., Wyeth G.F., Prasser D. RatSLAM: a hippocampal model for simultaneous localization and mapping. IEEE Int Conf Robot Autom 2004; 1: 403–408, https://doi.org/10.1109/robot.2004.1307183.