Технологии искусственного интеллекта в условиях микрохирургической операционной (обзор)

Проведение операции начинающим нейрохирургом под постоянным контролем старшего хирурга, который имеет опыт тысяч операций, умеет справляться со всевозможными интраоперационными осложнениями, может их заранее прогнозировать и при этом никогда не устает, является на данный момент несбыточной мечтой, но может стать реальностью с развитием методов искусственного интеллекта.

Представлен обзор литературы по теме применения технологий искусственного интеллекта в условиях микрохирургической операционной. Поиск источников проведен в текстовой базе данных медицинских и биологических публикаций PubMed. Использовали ключевые слова «surgical procedures», «dexterity», «microsurgery» AND «artificial intelligence OR machine learning OR neural networks». Рассматривали статьи на английском и русском языках без ограничения по дате публикации. Выделены основные направления исследований по применению технологий искусственного интеллекта в условиях микрохирургической операционной.

Несмотря на то, что в последние годы машинное обучение все активнее начинает внедряться в медицинскую отрасль, по интересующей нас проблеме опубликовано незначительное количество исследований, а их результаты пока не имеют практического применения. Однако социальная значимость данного направления служит важным аргументом для его развития.

Введение

В последние десятилетия наблюдается значительный интерес к практическому применению методов искусственного интеллекта (ИИ), в том числе машинного обучения, в области клинической медицины. Текущие успехи технологий ИИ в нейровизуализации открывают новые перспективы в развитии неинвазивной и персонализированной диагностики. Так, активно развиваются методы радиомики — извлечения большого количества признаков из медицинских изображений. Эти признаки могут содержать информацию для описания опухолей и структур мозга, которые не видны невооруженным глазом [1–5]. Предполагается, что правильное представление и анализ изображения с нейровизуализационными характеристиками поможет различать типы опухолей и соотносить их с клиническими проявлениями заболевания, прогнозом и наиболее эффективным лечением.

Технологии, оценивающие взаимосвязь между особенностями визуализации опухолей и экспрессией генов, получили название радиогеномики [6–9]. Эти методы направлены на создание визуализационных биомаркеров, которые могут идентифицировать генетические признаки заболевания без проведения биопсии.

Известны также успехи технологий ИИ в анализе молекулярных и генетических данных, сигналов от инвазивных датчиков, медицинских текстов. Универсальность подходов к применению ИИ открывает новые, оригинальные способы их использования в клинике.

С технической точки зрения термином «искусственный интеллект» можно обозначить математическую технологию, которая автоматизирует решение некоторой интеллектуальной задачи, традиционно решаемой человеком. В более широком смысле этим термином называют область компьютерных наук, в рамках которой такие решения разрабатываются.

Современный ИИ опирается на технологии машинного обучения — методы извлечения закономерностей и правил из репрезентативных для конкретной задачи данных (медицинских изображений, текстовых записей, генетических последовательностей, лабораторных анализов и т.д.). Например, технологии ИИ могут находить «правила» предсказания неблагоприятного исхода лечения по набору предикторов, ретроспективно «изучая» достаточное количество таких случаев с известными исходами. Это свойство ИИ можно использовать в задачах автоматизации отдельных процессов диагностики, выбора лечебной тактики или прогноза исходов медицинской помощи по клиническим данным.

В медицинской практике, в частности в хирургии, ИИ наряду с хирургическими роботами, 3D-печатью и новыми методами визуализации позволяет решать большой круг задач, повышая уровень точности и эффективности операций.

Для микрохирургии, когда речь идет о вмешательствах на малых анатомических структурах с использованием оптических средств и микрохирургического инструментария, применение ИИ имеет еще более важное значение.

Одной из задач использования ИИ в микрохирургии является автоматическое распознавание критически важных для микрохирурга анатомических структур (артерий, вен, нервов и др.) на интраоперационных фотографиях, видеоизображениях или изображениях анатомических препаратов. Решение этой задачи создает перспективы для разработки средств автоматического оповещения о рисках травматизации критически важных структур во время операции в режиме реального времени, выбора траекторий для безопасной диссекции или разрезов в функционально значимых областях [10].

Искусственный интеллект может оценить владение хирургическими инструментами, проконтролировать положение микроинструмента в руках хирурга (положение его в руке, отношение к операционной ране), тремор рук хирурга.

Перспективными задачами для ИИ в микрохирургии служат определение этапа операции, прогнозирование исходов и осложнений, создание основы интеллектуальной системы поддержки принятия интраоперационных решений во время микрохирургического вмешательства.

Нетривиальной задачей использования ИИ в микрохирургии является оценка навыков начинающих хирургов и ординаторов, а также улучшение техники у более опытных специалистов. Решение этой задачи в силу крайней сложности и ответственности работы микрохирурга позволит вывести данную область медицины на новые рубежи.

Для оценки имеющихся решений задачи использования ИИ в условиях микрохирургической операционной выполнен анализ статей в текстовой базе данных медицинских и биологических публикаций PubMed. Поиск литературы осуществляли по ключевым словам «surgical procedures», «dexterity», «microsurgery» AND «artificial intelligence OR machine learning OR neural networks» среди статей на английском и русском языках без ограничения по дате публикации.

Автоматическая оценка уровня микрохирургических навыков

Непрерывное обучение и постоянное совершенствование микрохирургической техники являются обязательными условиями формирования квалифицированного микрохирурга. Часто на обретение необходимого уровня микрохирургических навыков уходит бóльшая часть профессиональной жизни [11–13].

Микрохирургический тренинг требует постоянного участия наставника, который бы исправлял неоптимальные действия и движения микрохирурга, руководил процессом обучения. Можно провести параллель между подготовкой микрохирургов и олимпийских спортсменов: достижения высокого уровня невозможны без правильной системы подготовки и высокой квалификации тренеров. Однако вследствие большой клинической нагрузки и занятости опытных микрохирургов-наставников их постоянное присутствие в микрохирургической лаборатории невозможно, а старт обучения в условиях настоящей операционной вступает в противоречие с нормами медицинской этики. В этой ситуации технологии ИИ вполне можно использовать в процессе обучения для контроля за правильностью и эффективностью мануальных действий начинающего нейрохирурга.

К настоящему времени набор технологий ИИ, которые были бы адаптированы для анализа микрохирургических манипуляций, существенно ограничен. Например, в работах A. Bykanov c соавт. [14] и C.J. Coulson c соавт. [15] для оценки уровня микрохирургического тремора использовали акселерометры, прикрепленные к микрохирургическим инструментам. В работе K. Harada с соавт. [16] инфракрасные оптические маркеры отслеживания движения, инерциальный измерительный блок и тензодатчики были установлены на микрохирургическом пинцете для измерения пространственных параметров, связанных с манипуляциями с инструментом. Методы ИИ и машинного обучения в данной работе не применяли. M.A. Applebaum с соавт. [17] сравнили такие параметры, как время и количество движений в процессе выполнения микрохирургического задания пластическими хирургами с разным уровнем опыта, используя электромагнитное устройство отслеживания движения для записи перемещения рук хирурга. Такой подход к оценке производительности микронейрохирургических действий отличается объективностью и надежностью инструментальных измерений, но требует специального оборудования.

Экспертный анализ видеоизображений работы хирурга в условиях операционной может быть использован как альтернативный метод оценки степени овладения навыками микрохирургической техники. Однако привлечение эксперта к анализу таких изображений — времязатратный и крайне трудоемкий способ. Покадровый анализ движений микроинструмента по видеозаписям симуляционного хирургического действия был применен A. Óvári с соавт. [18]. Попытки объективно оценить и категорировать микрохирургическое действие на основе анализа видеозаписи микрохирургического тренинга сделаны в работе T. Satterwhite с соавт. [19]. Однако анализ и оценка действий обучающихся микрохирургов в данной работе были выполнены путем просмотра видеозаписей экспертами и выставления оценок по разработанной шкале, что не позволяет нивелировать влияние субъективного фактора на результаты анализа.

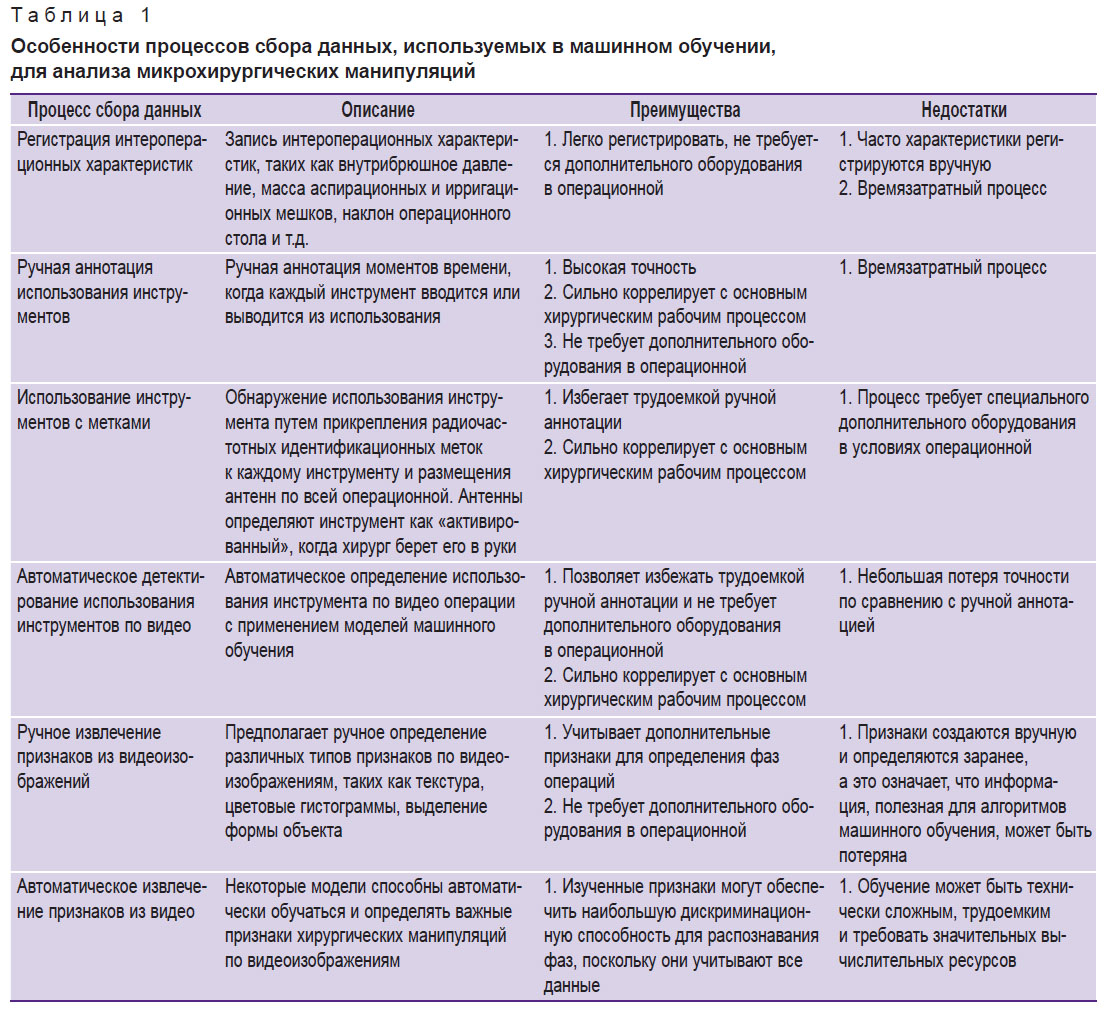

Многообещающей альтернативой указанным технологиям видятся методы машинного обучения, в первую очередь — компьютерное зрение, для автоматизированной оценки эффективности макро- и микрохирургических действий. Эти методы могут применяться на основе детекции и анализа перемещений микрохирургического инструмента в операционной ране. Проанализировав немногочисленную научную литературу по этой теме, мы обобщили основные процессы получения данных для анализа микрохирургических манипуляций с помощью машинного обучения (табл. 1).

|

Таблица 1. Особенности процессов сбора данных, используемых в машинном обучении, для анализа микрохирургических манипуляций |

Немногогочисленные данные научной литературы свидетельствуют о том, что методы машинного обучения позволяют выявлять сложные взаимосвязи в паттернах движений микрохирурга и прогнозировать параметры эффективности микрохирургического действия. Для реализации этих задач первым этапом необходимо обучить модель правильно классифицировать движение и сам микрохирургический инструмент в хирургическом видео. Исследования, выполняемые в настоящее время в данном направлении, в большинстве случаев сфокусированы на обучении компьютеров двум основным функциям: определению стадии хирургической операции и идентификации хирургического инструмента [20].

В работах по микрохирургии с применением машинного обучения чаще всего используют два вида источника данных: это видеозаписи операций [21] и набор переменных, которые получены с датчиков, закрепленных на микроинструментах или на теле оперирующего хирурга. Некоторые исследования комбинируют оба источника [22].

В исследовании N. Markarian с соавт. [21] модель глубокого обучения RetinaNet была создана для идентификации, локализации и аннотации хирургических инструментов по данным интраоперационных видеозаписей эндоскопических эндоназальных операций. Согласно выводам исследования, разработанная модель смогла успешно определять и правильно классифицировать хирургические инструменты. Однако все инструменты в работе относились к одному классу — «инструмент».

Интересное исследование выполнено D.J. Pangal с соавт. [23]. В данной работе авторы оценили возможности глубокой нейронной сети (DNN) предсказывать кровопотерю и исход повреждения внутренней сонной артерии по данным 1 мин видео, полученного из валидированного нейрохирургического тренажера для эндоназальной нейрохирургии. Результаты предсказания модели и экспертов в подавляющем большинстве случаев совпадали.

В работе R.B. McGoldrick с соавт. [24] исследователи для анализа плавности движений сосудистого микрохирурга, выполняющего микроанастамоз, использовали видеозаписи, сделанные непосредственно с камеры операционного микроскопа, и программу ProAnalyst, применив модель логистической регрессии и кубический сплайн.

I.T. Franco-González с соавт. [25] сконструировали стереоскопическую систему с использованием двух камер, которые записывают изображения с разных ракурсов хирургического пинцета. Программа для отслеживания 3D-движения была создана с применением языка программирования C++ и библиотеки OpenCV 3.4.11.

В работе M.M. Oliveira с соавт. [26] показано, что применение машинного обучения и компьютерного зрения при моделировании микрохирургических операций позволяет улучшить базовые навыки как ординаторов, так и специалистов с большим опытом.

Значительным шагом вперед в процессе улучшения распознавания этапов операции стало использование в алгоритмах анализа нейронных сетей с длительной кратковременной памятью (LSTM), что позволило улучшить точность определения фазы операции до 85–90%.

Важно отметить, что в связи с типичными ограничениями объема данных разработчики моделей часто применяют так называемое трансферное обучение [27], которое позволяет предобучить модель на одних данных (чаще всего — на открытых наборах, с помощью которых решают схожие задачи в той же предметной области) и затем дообучить на других, на которых решается целевая задача. В настоящее время известны следующие наборы открытых данных, которые используют в решении задач, связанных с оценкой точности хирургических операций:

EndoVis Challenge datasets — коллекция размеченных наборов данных, которые содержат видеозаписи различных типов хирургических операций для задач классификации, сегментации, детекции, локализации и т.д. [28];

Cholec80 — 80 видеозаписей эндоскопических операций, выполняемых 13 разными хирургами; все видео размечены с учетом фаз операций и наличия инструментов в кадре [29];

MICCAI challenge datasets — набор данных, который позволяет проводить большое количество соревнований по анализу медицинских данных, в том числе и по анализу материалов хирургических операций [30];

JHU-ISI и JIGSAWS — размеченный набор данных видеозаписей операций, проводимых восемью хирургами с тремя уровнями квалификации, которые выполнили в общей сложности 103 базовых роботизированных лабораторных испытания [31];

ATLAS Dione — 99 видеозаписей 6 типов операций, выполняемых 10 разными хирургами с помощью робот-ассистированной системы «да Винчи» (da Vinci Surgical System). Размер кадра — 854×480 пк, каждый из которых размечен на предмет наличия в кадре хирургических инструментов [32].

Теоретически можно использовать сотни и тысячи видеозаписей с целью их анализа с помощью методов машинного обучения. Однако для обучения модели необходимо просматривать и выполнять в «ручном режиме» разметку видеоизображений, что требует большого количества времени. Возможным решением данной проблемы является использование новых алгоритмов, способных самостоятельно выполнять аннотацию видеофайлов [33].

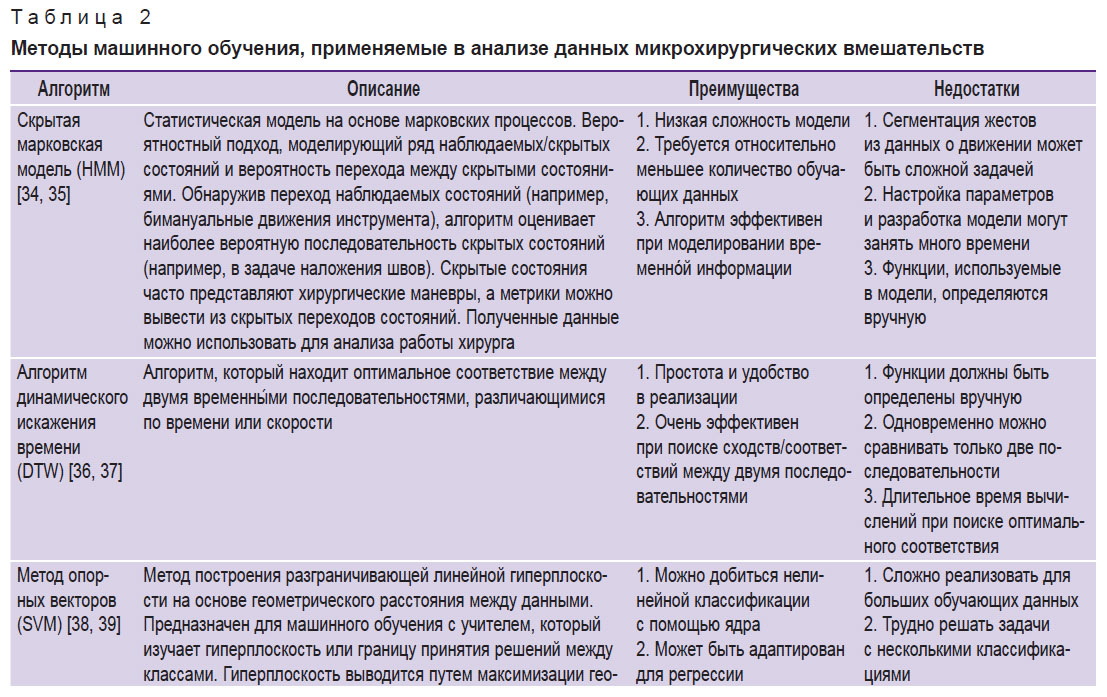

В табл. 2 мы приводим список методов машинного обучения, применяемых, по данным научной литературы, в анализе видеоизображений микрохирургических вмешательств, с их краткой характеристикой.

|

Таблица 2. Методы машинного обучения, применяемые в анализе данных микрохирургических вмешательств |

Большинство исследований с использованием ИИ для анализа микронейрохирургических действий выполнены на моделях самых простых хирургических манипуляций, отдельных элементарных этапов операций (например, наложение швов, выполнение надрезов). Очевидно, что пилотные исследования в этой сфере обычно начинают с упрощенных моделей. Однако операция — это сложный комплекс разнообразных факторов, влияющих на хирургическую технику и результаты манипуляций, которые сложно учесть в эксперименте. И поэтому перенос моделей машинного обучения из экспериментальных условий в реальную практику не может гарантировать высокого качества работы, чем снижает их ценность.

Заключение

Несмотря на быстрое развитие методов машинного обучения в области клинической медицины, пока они находятся в начальной фазе апробации в задачах оценки микрохирургической техники и скорое внедрение их в повседневную клиническую практику маловероятно. Однако имеются все основания считать, что использование технологий машинного обучения, в частности компьютерного зрения, в микрохирургии имеет хороший потенциал для улучшения процесса обучения микрохирургической технике в будущем. И это служит хорошей предпосылкой для развития особого направления искусственного интеллекта в области микронейрохирургии.

Финансирование. Исследование выполнено за счет гранта Российского научного фонда, проект №22-75-10117.

Конфликт интересов. У авторов нет конфликта интересов.

Литература

- Jian A., Jang K., Manuguerra M., Liu S., Magnussen J., Di Ieva A. Machine learning for the prediction of molecular markers in glioma on magnetic resonance imaging: a systematic review and meta-analysis. Neurosurgery 2021; 89(1): 31–44, https://doi.org/10.1093/neuros/nyab103.

- Litvin A.A., Burkin D.A., Kropinov A.A., Paramzin F.N. Radiomics and digital image texture analysis in oncology (review). Sovremennye tehnologii v medicine 2021; 13(2): 97, https://doi.org/10.17691/stm2021.13.2.11.

- Ning Z., Luo J., Xiao Q., Cai L., Chen Y., Yu X., Wang J., Zhang Y. Multi-modal magnetic resonance imaging-based grading analysis for gliomas by integrating radiomics and deep features. Ann Transl Med 2021; 9(4): 298, https://doi.org/10.21037/atm-20-4076.

- Lambin P., Rios-Velazquez E., Leijenaar R., Carvalho S., van Stiphout R.G., Granton P., Zegers C.M., Gillies R., Boellard R., Dekker A., Aerts H.J. Radiomics: extracting more information from medical images using advanced feature analysis. Eur J Cancer 2012; 48(4): 441–446, https://doi.org/10.1016/j.ejca.2011.11.036.

- Habib A., Jovanovich N., Hoppe M., Ak M., Mamindla P., Colen R.R., Zinn P.O. MRI-based radiomics and radiogenomics in the management of low-grade gliomas: evaluating the evidence for a paradigm shift. J Clin Med 2021; 10(7): 1411, https://doi.org/10.3390/jcm10071411.

- Cho H.H., Lee S.H., Kim J., Park H. Classification of the glioma grading using radiomics analysis. PeerJ 2018; 6: e5982, https://doi.org/10.7717/peerj.5982/supp-3.

- Su C., Jiang J., Zhang S., Shi J., Xu K., Shen N., Zhang J., Li L., Zhao L., Zhang J., Qin Y., Liu Y., Zhu W. Radiomics based on multicontrast MRI can precisely differentiate among glioma subtypes and predict tumour-proliferative behaviour. Eur Radiol 2019; 29(4): 1986–1996, https://doi.org/10.1007/s00330-018-5704-8.

- Cao X., Tan D., Liu Z., Liao M., Kan Y., Yao R., Zhang L., Nie L., Liao R., Chen S., Xie M. Differentiating solitary brain metastases from glioblastoma by radiomics features derived from MRI and 18F-FDG-PET and the combined application of multiple models. Sci Rep 2022; 12(1): 5722, https://doi.org/10.1038/s41598-022-09803-8.

- Qian J., Herman M.G., Brinkmann D.H., Laack N.N., Kemp B.J., Hunt C.H., Lowe V., Pafundi D.H. Prediction of MGMT status for glioblastoma patients using radiomics feature extraction from 18F-DOPA-PET imaging. Int J Radiat Oncol Biol Phys 2020; 108(5): 1339–1346, https://doi.org/10.1016/j.ijrobp.2020.06.073.

- Witten A.J., Patel N., Cohen-Gadol A. Image segmentation of operative neuroanatomy into tissue categories using a machine learning construct and its role in neurosurgical training. Oper Neurosurg (Hagerstown) 2022; 23(4): 279–286, https://doi.org/10.1227/ons.0000000000000322.

- Лихтерман Л.Б. Врачевание: стандарты и творчество. Нейрохирургия 2020; 22(2): 105–108, https://doi.org/10.17650/1683-3295-2020-22-2-105-108.

- Гусев Е.И., Бурд Г.С., Коновалов А.Н. Неврология и нейрохирургия. Медицина; 2000; URL: http://snsk.az/snsk/file/2013-05-9_11-31-06.pdf.

- Крылов В.В., Коновалов А.Н., Дашьян В.Г., Кондаков Е.Н., Таняшин С.В., Горелышев С.К., Древаль О.Н., Гринь А.А., Парфенов В.Е., Кушнирук П.И., Гуляев Д.А., Колотвинов В.С., Рзаев Д.А., Пошатаев К.Е., Кравец Л.Я., Можейко Р.А., Касьянов В.А., Кордонский А.Ю., Трифонов И.С., Каландари А.А., Шатохин Т.А., Айрапетян А.А., Далибалдян В.А., Григорьев И.В., Сытник А.В. Состояние нейрохирургической службы Российской Федерации. Вопросы нейрохирургии им. Н.Н. Бурденко 2017; 81(1): 5–12, https://doi.org/10.17116/neiro20178075-12.

- Bykanov A., Kiryushin M., Zagidullin T., Titov O., Rastvorova O. Effect of energy drinks on microsurgical hand tremor. Plast Reconstr Surg Glob Open 2021; 9(4): e3544, https://doi.org/10.1097/gox.0000000000003544.

- Coulson C.J., Slack P.S., Ma X. The effect of supporting a surgeon’s wrist on their hand tremor. Microsurgery 2010; 30(7): 565–568, https://doi.org/10.1002/micr.20776.

- Harada K., Morita A., Minakawa Y., Baek Y.M., Sora S., Sugita N., Kimura T., Tanikawa R., Ishikawa T., Mitsuishi M. Assessing microneurosurgical skill with medico-engineering technology. World Neurosurg 2015; 84(4): 964–971, https://doi.org/10.1016/j.wneu.2015.05.033.

- Applebaum M.A., Doren E.L., Ghanem A.M., Myers S.R., Harrington M., Smith D.J. Microsurgery competency during plastic surgery residency: an objective skills assessment of an integrated residency training program. Eplasty 2018;18: e25.

- Óvári A., Neményi D., Just T., Schuldt T., Buhr A., Mlynski R., Csókay A., Pau H.W., Valálik I. Positioning accuracy in otosurgery measured with optical tracking. PLoS One 2016; 11(3): e0152623, https://doi.org/10.1371/journal.pone.0152623.

- Satterwhite T., Son J., Carey J., Echo A., Spurling T., Paro J., Gurtner G., Chang J., Lee G.K. The Stanford Microsurgery and Resident Training (SMaRT) scale: validation of an on-line global rating scale for technical assessment. Ann Plast Surg 2014; 72(Suppl 1): S84–S88, https://doi.org/10.1097/sap.0000000000000139.

- Ward T.M., Mascagni P., Ban Y., Rosman G., Padoy N., Meireles O., Hashimoto D.A. Computer vision in surgery. Surgery 2021; 169(5): 1253–1256, https://doi.org/10.1016/j.surg.2020.10.039.

- Markarian N., Kugener G., Pangal D.J., Unadkat V., Sinha A., Zhu Y., Roshannai A., Chan J., Hung A.J., Wrobel B.B., Anandkumar A., Zada G., Donoho D.A. Validation of machine learning-based automated surgical instrument annotation using publicly available intraoperative video. Oper Neurosurg (Hagerstown) 2022; 23(3): 235–240, https://doi.org/10.1227/ons.0000000000000274.

- Jin A., Yeung S., Jopling J., Krause J., Azagury D., Milstein A., Fei-Fei L. Tool detection and operative skill assessment in surgical videos using region-based convolutional neural networks. In: Proc 2018 IEEE Winter Conf Appl Comput Vision WACV 2018; p. 691–699, https://doi.org/10.1109/wacv.2018.00081.

- Pangal D.J., Kugener G., Zhu Y., Sinha A., Unadkat V., Cote D.J., Strickland B., Rutkowski M., Hung A., Anandkumar A., Han X.Y., Papyan V., Wrobel B., Zada G., Donoho D.A. Expert surgeons and deep learning models can predict the outcome of surgical hemorrhage from 1 min of video. Sci Rep 2022; 12(1): 8137, https://doi.org/10.1038/s41598-022-11549-2.

- McGoldrick R.B., Davis C.R., Paro J., Hui K., Nguyen D., Lee G.K. Motion analysis for microsurgical training: objective measures of dexterity, economy of movement, and ability. Plast Reconstr Surg 2015; 136(2): 231e–240e, https://doi.org/10.1097/prs.0000000000001469.

- Franco-González I.T., Pérez-Escamirosa F., Minor-Martínez A., Rosas-Barrientos J.V., Hernández-Paredes T.J. Development of a 3D motion tracking system for the analysis of skills in microsurgery. J Med Syst 2021; 45(12): 106, https://doi.org/10.1007/s10916-021-01787-8.

- Oliveira M.M., Quittes L., Costa P.H.V., Ramos T.M., Rodrigues A.C.F., Nicolato A., Malheiros J.A., Machado C. Computer vision coaching microsurgical laboratory training: PRIME (Proficiency Index in Microsurgical Education) proof of concept. Neurosurg Rev 2022; 45(2): 1601–1606, https://doi.org/10.1007/s10143-021-01663-6.

- Wang J., Zhu H., Wang S.H., Zhang Y.D. A review of deep learning on medical image analysis. Mob Networks Appl 2020; 26: 351–380, https://doi.org/10.1007/s11036-020-01672-7.

- Du X., Kurmann T., Chang P.L., Allan M., Ourselin S., Sznitman R., Kelly J.D., Stoyanov D. Articulated multi-instrument 2-D pose estimation using fully convolutional networks. IEEE Trans Med Imaging 2018; 37(5): 1276–1287, https://doi.org/10.1109/tmi.2017.2787672.

- Twinanda A.P., Shehata S., Mutter D., Marescaux J., de Mathelin M., Padoy N. EndoNet: a deep architecture for recognition tasks on laparoscopic videos. IEEE Trans Med Imaging 2017; 36(1): 86–97, https://doi.org/10.1109/tmi.2016.2593957.

- Commowick O., Kain M., Casey R., Ameli R., Ferré J.C., Kerbrat A., Tourdias T., Cervenansky F., Camarasu-Pop S., Glatard T., Vukusic S., Edan G., Barillot C., Dojat M., Cotton F. Multiple sclerosis lesions segmentation from multiple experts: the MICCAI 2016 challenge dataset. Neuroimage 2021; 244: 118589, https://doi.org/10.1016/j.neuroimage.2021.118589.

- Gao Y., Vedula S.S., Reiley C.E., Ahmidi N., Varadarajan B., Lin H.C., Tao L., Zappella L., Béjar B., Yuh D.D., Chen C.C.G., Vidal R., Khudanpur S., Hager G.D. JHU-ISI Gesture And Skill Assessment Working Set (JIGSAWS): a surgical activity dataset for human motion modeling. 2022. URL: https://cirl.lcsr.jhu.edu/wp-content/uploads/2015/11/JIGSAWS.pdf.

- Sarikaya D., Corso J.J., Guru K.A. Detection and localization of robotic tools in robot-assisted surgery videos using deep neural networks for region proposal and detection. IEEE Trans Med Imaging 2017; 36(7): 1542–1549, https://doi.org/10.1109/tmi.2017.2665671.

- Yu T., Mutter D., Marescaux J., Padoy N. Learning from a tiny dataset of manual annotations: a teacher/student approach for surgical phase recognition. arXiv; 2018, https://doi.org/10.48550/arxiv.1812.00033.

- Ahmidi N., Poddar P., Jones J.D., Vedula S.S., Ishii L., Hager G.D., Ishii M. Automated objective surgical skill assessment in the operating room from unstructured tool motion in septoplasty. Int J Comput Assist Radiol Surg 2015; 10(6): 981–991, https://doi.org/10.1007/s11548-015-1194-1.

- Rosen J., Hannaford B., Richards C.G., Sinanan M.N. Markov modeling of minimally invasive surgery based on tool/tissue interaction and force/torque signatures for evaluating surgical skills. IEEE Trans Biomed Eng 2001; 48(5): 579–591, https://doi.org/10.1109/10.918597.

- Jiang J., Xing Y., Wang S., Liang K. Evaluation of robotic surgery skills using dynamic time warping. Comput Methods Programs Biomed 2017; 152: 71–83, https://doi.org/10.1016/j.cmpb.2017.09.007.

- Peng W., Xing Y., Liu R., Li J., Zhang Z. An automatic skill evaluation framework for robotic surgery training. Int J Med Robot 2019; 15(1): e1964, https://doi.org/10.1002/rcs.1964.

- Poursartip B., LeBel M.E., McCracken L.C., Escoto A., Patel R.V., Naish M.D., Trejos A.L. Energy-based metrics for arthroscopic skills assessment. Sensors (Basel) 2017; 17(8): 1808, https://doi.org/10.3390/s17081808.

- Gorantla K.R., Esfahani E.T. Surgical skill assessment using motor control features and hidden Markov model. Annu Int Conf IEEE Eng Med Biol Soc 2019; 2019: 5842–5845, https://doi.org/10.1109/embc.2019.8857629.

- Bissonnette V., Mirchi N., Ledwos N., Alsidieri G., Winkler-Schwartz A., Del Maestro R.F.; Neurosurgical Simulation & Artificial Intelligence Learning Centre. Artificial intelligence distinguishes surgical training levels in a virtual reality spinal task. J Bone Joint Surg Am 2019; 101(23): e127, https://doi.org/10.2106/jbjs.18.01197.

- Winkler-Schwartz A., Yilmaz R., Mirchi N., Bissonnette V., Ledwos N., Siyar S., Azarnoush H., Karlik B., Del Maestro R. Machine learning identification of surgical and operative factors associated with surgical expertise in virtual reality simulation. JAMA Netw Open 2019; 2(8): e198363, https://doi.org/10.1001/jamanetworkopen.2019.8363.

- Hung A.J., Chen J., Che Z., Nilanon T., Jarc A., Titus M., Oh P.J., Gill I.S., Liu Y. Utilizing machine learning and automated performance metrics to evaluate robot-assisted radical prostatectomy performance and predict outcomes. J Endourol 2018; 32(5): 438–444, https://doi.org/10.1089/end.2018.0035.

- Baghdadi A., Hussein A.A., Ahmed Y., Cavuoto L.A., Guru K.A. A computer vision technique for automated assessment of surgical performance using surgeons console-feed videos. Int J Comput Assist Radiol Surg 2019; 14(4): 697–707, https://doi.org/10.1007/s11548-018-1881-9.

- Yamaguchi T., Suzuki K., Nakamura R. Development of a visualization and quantitative assessment system of laparoscopic surgery skill based on trajectory analysis from USB camera image. Int J Comput Assist Radiol Surg 2016; 11(suppl): S254–S256.

- Weede O., Möhrle F., Wörn H., Falkinger M., Feussner H. Movement analysis for surgical skill assessment and measurement of ergonomic conditions. In: 2014 2nd International Conference on Artificial Intelligence, Modelling and Simulation. IEEE; 2014; p. 97–102, https://doi.org/10.1109/aims.2014.69.

- Kelly J.D., Petersen A., Lendvay T.S., Kowalewski T.M. Bidirectional long short-term memory for surgical skill classification of temporally segmented tasks. Int J Comput Assist Radiol Surg 2020; 15(12): 2079–2088, https://doi.org/10.1007/s11548-020-02269-x.

- Gahan J., Steinberg R., Garbens A., Qu X., Larson E. MP34-06 machine learning using a multi-task convolutional neural networks can accurately assess robotic skills. J Urol 2020; 203(Suppl 4): e505, https://doi.org/10.1097/ju.0000000000000878.06.

- Liu Y., Zhao Z., Shi P., Li F. Towards surgical tools detection and operative skill assessment based on deep learning. IEEE Trans Med. Robot Bionics 2022; 4(1): 62–71, https://doi.org/10.1109/tmrb.2022.3145672.